NSX-T Manager Cluster Kurulum ve İncelemesi

Merhaba, Serinin ikinci yazısı NSX Manager Cluster kurulumu ve incelemesi ile birlikteyiz. Bu yazımda NSX Manager cluster’ın genel yapısı, ne iş yaptığı, gereksinimleri ve nasıl kurulduğu konularından bahsedeceğim.

Öncelikle NSX-T Genel Mimari ve konseptler hakkında bilgi sahibi olmak için şu yazıdan başlamanızı öneririm: NSX-T Data Center Nedir? Genel Mimari

NSX Manager Nedir?

NSX Manager içerisinde NSX controller’ı da barındıran, grafiksel ve REST API yoluyla sistem geneli konfigürasyonları yapabilmemizi sağlayan, management plane’de bulunan yönetim modülüdür. NSX Manager Management Plane Agent (MPA) yardımı ile kendi domaininde (Transport Zone) olan tüm hypervisor’ları desired state’de tutma işini yapar.

Daha önce anlattığım üzere NSX Manager, içerisinde controller barındırmaktadır. Bu durumda NSX Manager deploy ettiğimizde 1 adet de controller sahibi olmaktayız. Şunu göz ardı etmemeliyiz ki hem manager hem de controller sağlığı NSX-T ortamı için kesinlikle kritiktir.

NSX Manager için network bazında stardart bir VM’den farklı olarak ek bir ister yoktur. IP bağlantısı sağlamak yeterlidir. Sağlanan VLAN bazlı bir IP bağlantısı ile NSX Manager (Controller), yeterli kapasiteye sahip olacaktır. Data interface’inde her hangi bir enkapsülasyon bulunmamakla birlikte MTU bazında değerlendirdiğimizde 1500 standart MTU yeterlidir.

NSX Manager içerisinde iki adet rol ve iki adet UI barındırmaktadır.

Policy Rolü:

Bu rol “basitleştirilmiş” diyebileceğimiz bir UI sağlamakla yükümlüdür. Basitleştirilmiş kelimesini daha iyi anlamak için şöyle örnek verebilirim;

Bir iş yapmak istiyorsunuz ancak bu iş için gerekli elemanların hangi sıralama ile yaratılıp nasıl birbirine bağlanması konusunda kararsız durumdasınız. Policy Manager bu noktada iş için gerekli tüm bağımlılıkları sıralamaya bakmaksızın yaratabileceğiniz ve birbirine iliştirebileceğiniz tek bir ekran sunuyor.

Manager Rolü:

Takımın bel kemiğidir kendisi tüm sistem bu rol etrafına inşa edilmiştir. User ile CCP arasında köprü vazifesi görmektedir. Yine Policy rolünden gelen isteklerde buraya iletilmekte ve buradan işleme alınmaktadır. Bu noktada dikkat edilmesi gereken bazı noktalar vardır.

Simplified UI (Policy) vs Advanced UI (Manager)

NSX Manager UI’da 3.0 öncesi sürümlerde Advanced Networking & Security sekmesi altında yapmış olduğunuz her şey direkt olarak Manager Rolü ile ilişkilidir ve Policy Manager’ın burada tanımlanan objeler üzerinde söz hakkı veya farkındalığı yoktur. NSX-T 3.0 ve sonrasında ise arayüz değişmiş ve ekranın sağ üst köşesine seçenekler halinde eklenmiş durumda. Bunları bir kenara bırakırsak VMware uzun süredir Manager Rolünü UI’dan kaldırmayı ve sadece Policy rolü ile devam etmeyi planlamakta bu yüzden eğer ki önceden tanımlamış olduğunuz objeleriniz yoksa Manager rolünü kullanmanızı tavsiye etmem. Çünkü burada yaratılan objeler Policy Manager tarafından görülememekte. Yarın öbürgün burdaki objeleri Policy tarafına geçirmek için ek efor sarfedebilirsiniz bunu unutmamak gerek.

Konu hakkında daha fazla bilgi almak isterseniz Veeam Software’dan Jeffrey Kusters’in çok güzel bir yazısı bulunmakta linki bırakıyorum;

https://www.veeam.com/blog/nsxt-simplified-vs-advanced-ui.html

Neden Cluster’a ihtiyaç var?

Cluster mekanizması hepimizin bildiği üzere temel olarak yedeklilik ve iş devamlılığı sağlamak üzerine oluşturulmuş bir mekanizmadır. Yedeklilik ve iş devamlılığının yanı sıra iş yükünün paylaşımı da cluster mekanizması sayesinde mümkün olabilmektedir. NSX Manager açısından konuyu inceleyecek olursak cluster mekanizması UI için yüksek seviyede erişilebilirlik ve Central Conrol Plane (CCP) için iş devamlılığını temsil etmektedir. Bu noktada 2.4 öncesi sürümlerde bulunan Manager ve Controller VM’lerinin ayrı olması durumu 2.4+ sürümlerde fiziksel olarak birleştirilerek mantıksal bir ayrışma oluşturulmuş ve bu sayede toplamda deploy edilecek instance sayısı azalmış aynı zamanda yönetim kolaylığı oluşmuştur. Tüm bunlarla birlikte NSX Manager Clustering mimarisi sayesinde CCP’de bulunan iş yükü dağıtık bir şekilde devam etmiş ve network slicing süregelmiştir.

NSX Manager Cluster Mimarisi

NSX Manager Cluster Mimarisinde üç adet VM bulunmaktadır. Bu VM’ler ESXi veya KVM üzerinde konumlandırılabilir. Üç VM için HA Proxy olacak şekilde bir VIP belirlemek mümkündür. Bu VIP arka tarafta işi yapan bir manager’a bind edilecek şekilde çalışmaktadır. Örnek olarak üç managerimiz olsun;

Manager 1 : 1.1.1.1

Manager 2 : 1.1.1.2

Manager 3 : 1.1.1.3

HA VIP : 1.1.1.4

Bu noktada browser’a https://1.1.1.4 adresini yazdığımızda karşımıza gelen sayfa arkada manager’lardan birisi olacaktır. Ancak bunun gerçek anlamda bir önemi yoktur çünkü NSX içerisinde bulunan tüm manager’lar aynı database’i anlık olarak update etmekte ve paylaşmaktadır. Yani 1 , 2 veya 3 numaralı Manager’a bağlanarak işlemlerinizi yapabilirsiniz. Nerede işlem yaptığınızın bir önemi yoktur.

Yukarıda belirttiğim üzere nere işlem yaptığınızın bir önemi olmadığı gibi tüm node’ları kaybetmediğiniz sürece her hangi bir node’u da kaybetmenizin bir önemi yoktur. Basit olarak fail olmuş bir node’u onarmak yerine remove edip yenisini deploy edebilirsiniz. Mevcut mimaride önemli noktalardan birisi şudur; 3 Node içeren NSX Manager Cluster içerisinde 1 Node kaybederseniz sistem çalışmaya devam eder. 2.Node’u kaybederseniz sistem Read-only duruma geçer ve sizin diğer node’ları ayağa kaldırmanızı bekler. Tüm node’ları kaybederseniz networkünüzde herhangi bir kesinti oluşmaz. Ancak yeni bir konfigürasyon yapamazsınız.

NSX Manager Cluster kurulum gereksinimleri nelerdir?

- 4 adet IP adresi

- vCenter Server ve ESXi hostlara erişim için firewall gereksinimleri

https://ports.vmware.com/home/NSX-T-Data-Center - Boyuta göre gerekli vCPU, RAM ve Datastore

- Manager Nodeları arasında maksimum 10ms gecikme

- O/S gereksinimleri ; NSX Manager Requirements

NSX Manager Cluster Kurulumu (UI)

Genel konfigürasyon;

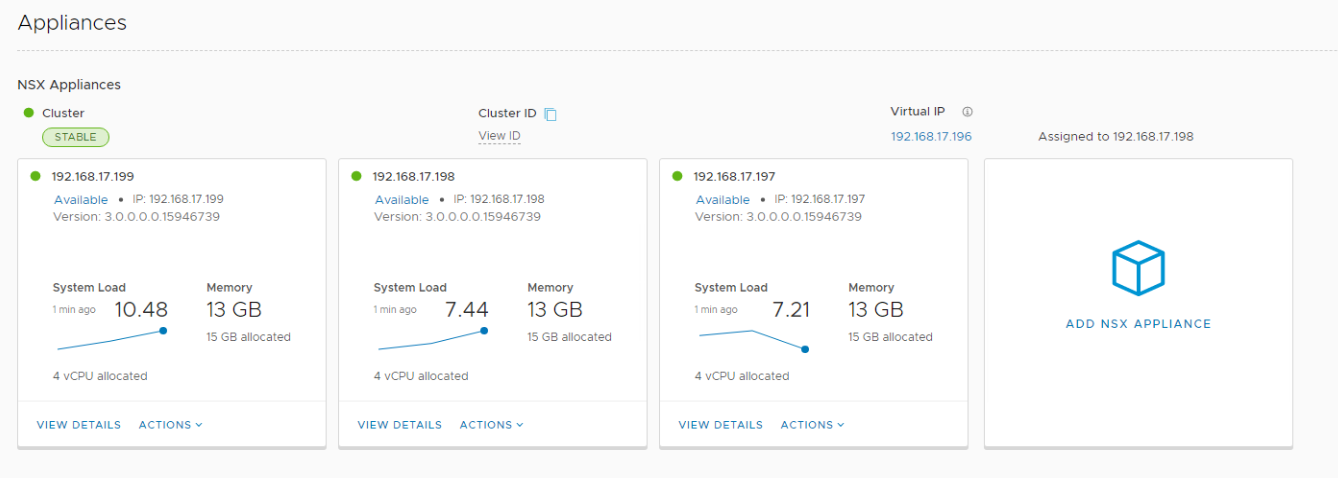

Birinci NSX Manager : 192.168.17.199

İkinci NSX Manager : 192.168.17.198

Üçüncü NSX Manager : 192.168.17.197

NSX Manager HA VIP : 192.168.17.196

NSX Manager UI üzerinden cluster deployment’i yapabilmek için öncelikle bir compute manager olması gerekmektedir ve şuan için tek tip (vCenter) compute manager seçeneğimiz bulunmakta. Sonrasında eklenen compute manager hedef gösterilerek appliance deployment’leri yapılabilir.

Compute Manager Ekleme;

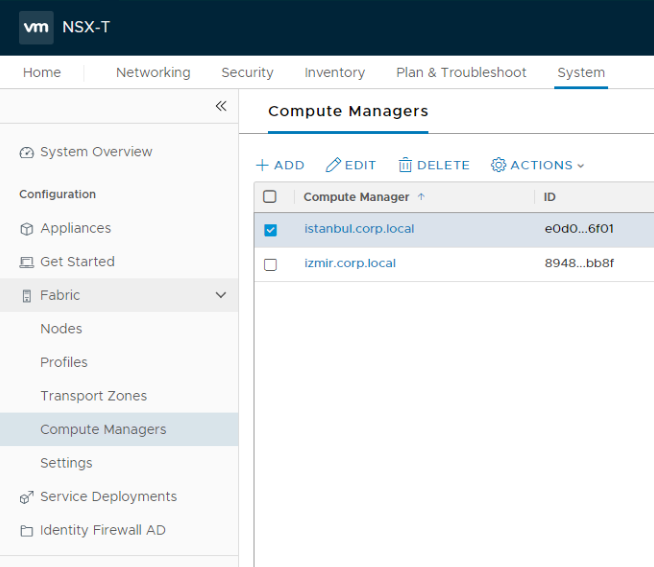

NSX-T UI dan System > Fabric > Compute Managers sekmesine tıkladığımızda bizi ekleme değiştirme çıkarma ve tagleme yapabileceğimiz bir ekran karşılıyor.

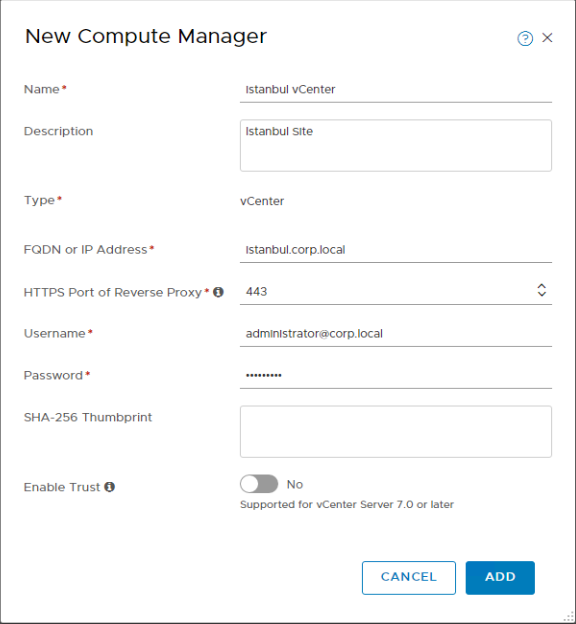

Bu noktada + ADD basarak devam ediyorum. Gelen ekranda gerekli bilgileri dolduruyorum. Ne isim verdiğimiz çok önemli değil türkçe karakter kullanmamaya özen gösterelim yeterli. Burada Enable Trust sadece 7.0 ve sonrası sürümlerde kullanılabilir. Bilgileri girip ADD tuşuna bastığımızda bize vCenter thumbprinti verecektir. Onaylayarak devam ediyoruz.

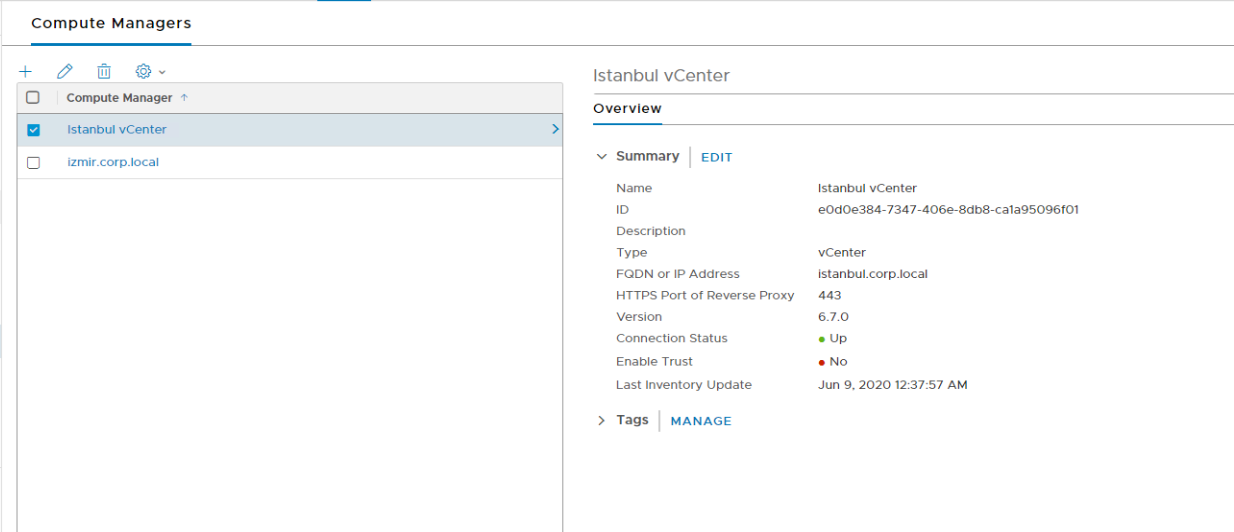

Ekleme işlemi tamamlandığında isme basarak genel durum hakkında bilgi edinebilirim. Eğer ki connectivity status UP durumda ise devamı için bu yeterlidir.

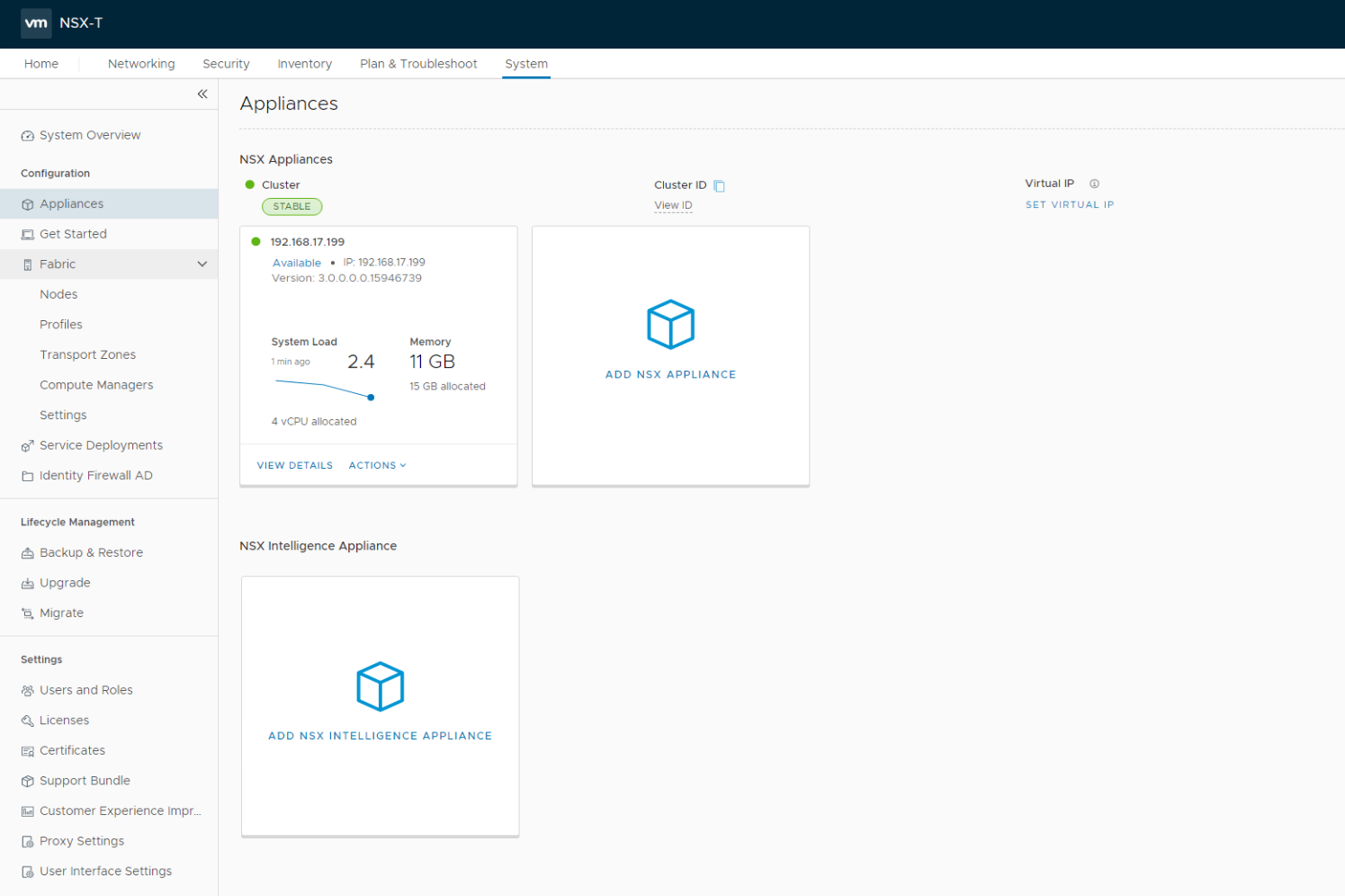

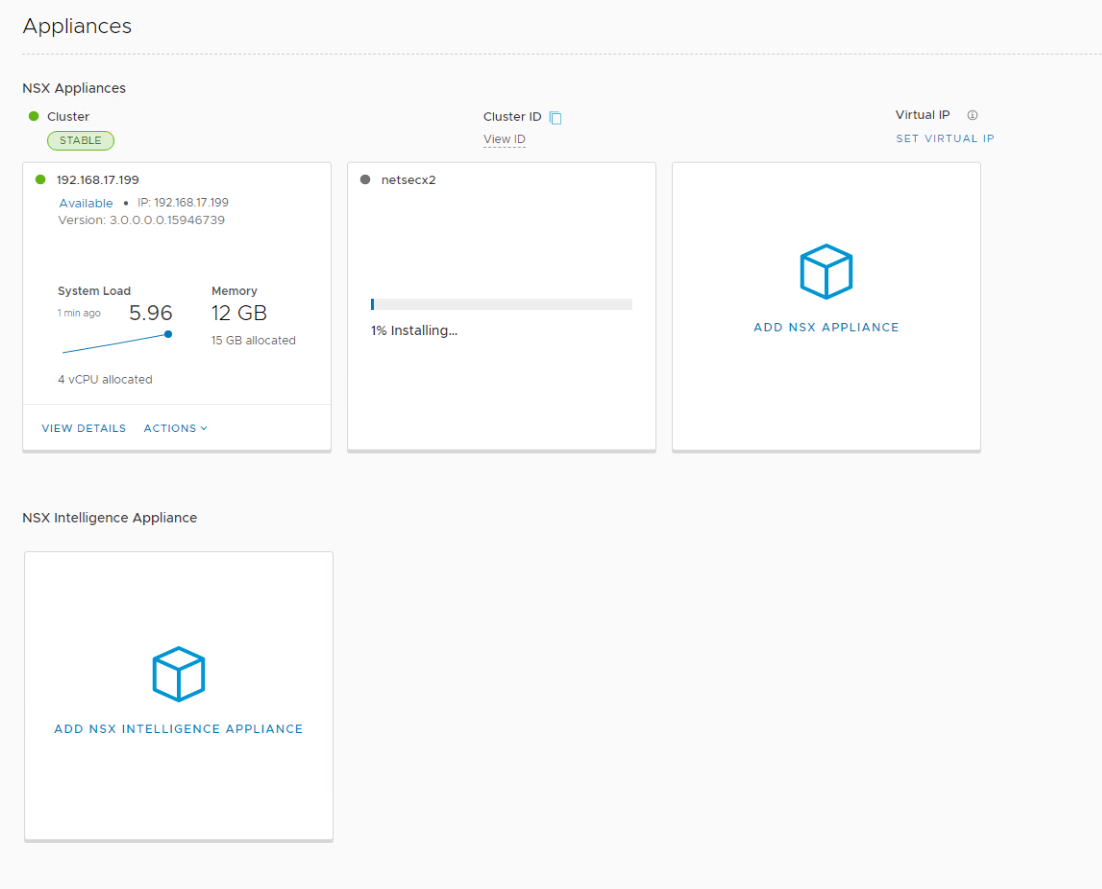

Cluster’a Node ekleme

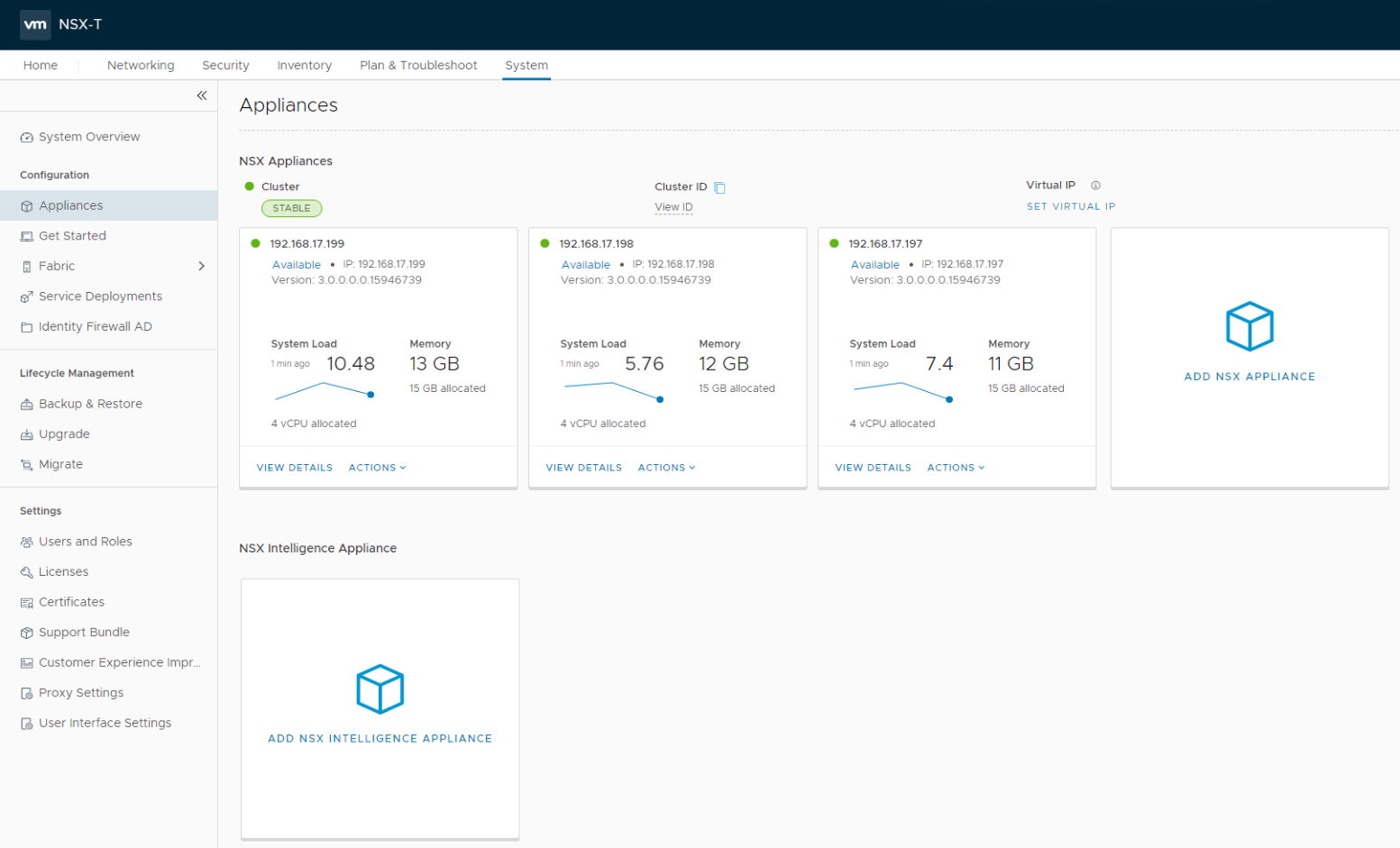

NSX Manager UI’da System > Appliances yoluna gittiğimde birincil NSX manager’i görüyoruz. Bu noktada ADD NSX APPLIANCE kutucuğuna tıklayarak devam ediyorum.

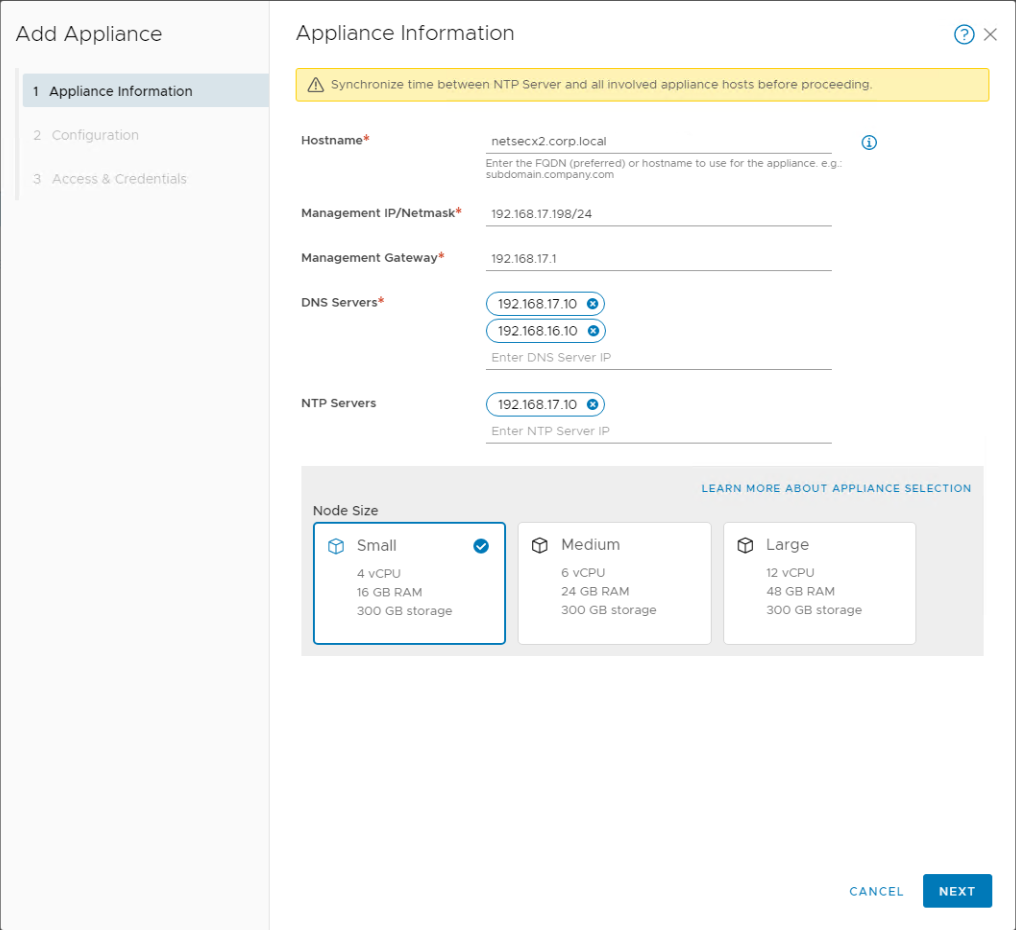

Gerekli bilgileri doldurarak devam ediyorum. Bu noktada DNS ve NTP’yi girmeniz çok önemli. NTP’nin kesinlikle çalıştığından emin olmalısınız.

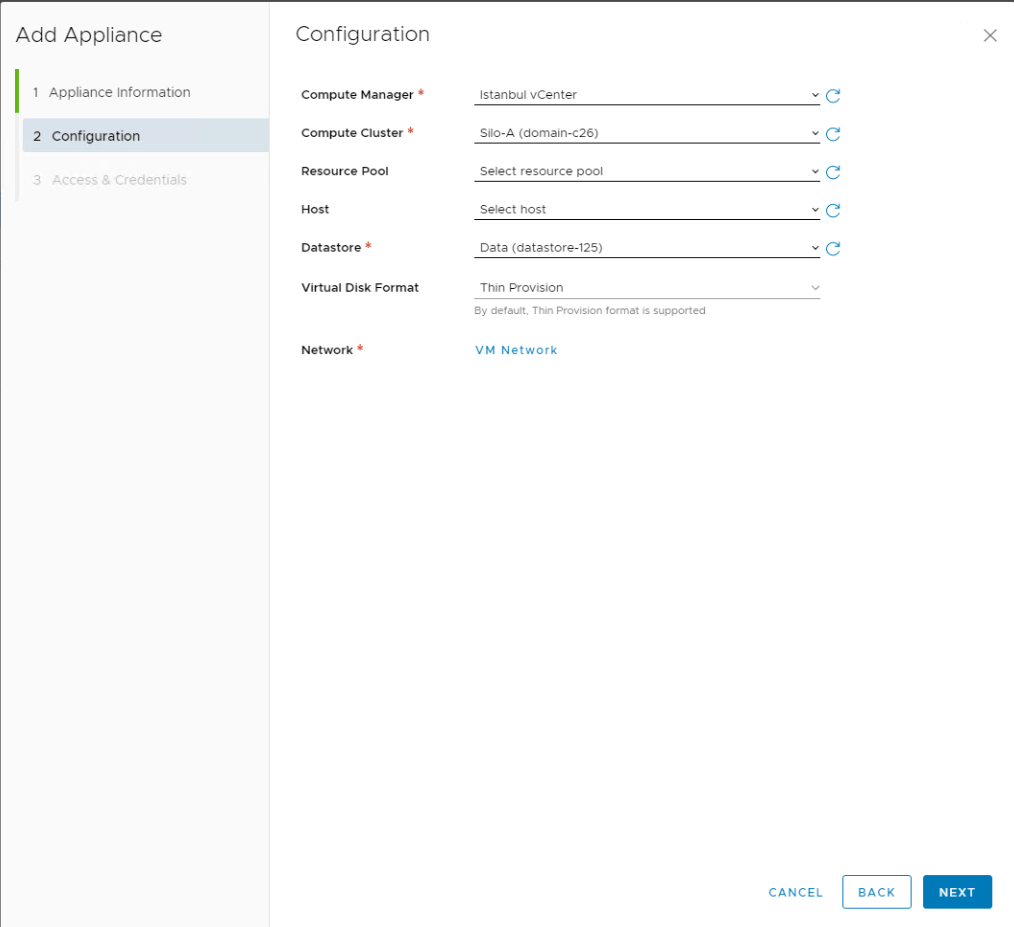

Configuration adımında bizlere hangi vCenter’a deploy edileceği, datastore , network yerleşimleri soruluyor. İlgili ayarları seçerek devam ediyorum.

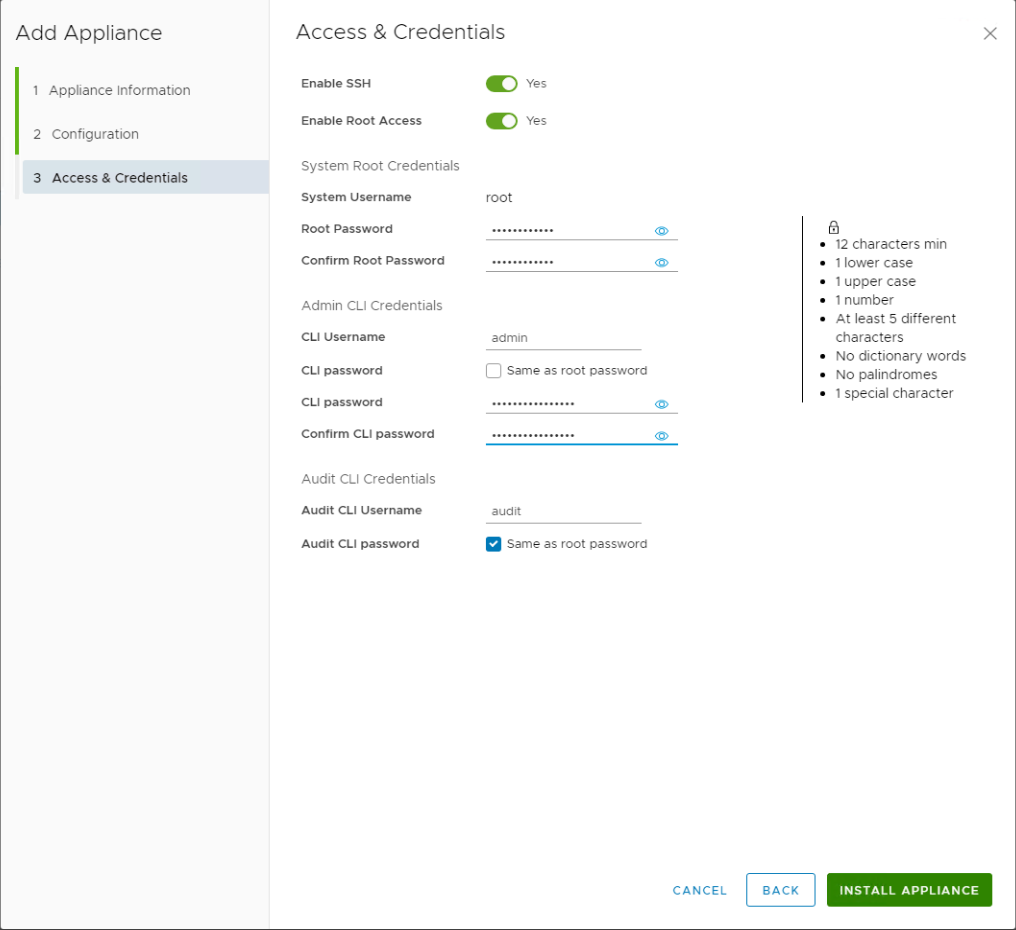

Üçüncü adımda Enable SSH ve Enable Root Access seçeneklerini işaretleyerek root admin ve audit userlarına şifre tanımlaması yapıyorum.

Bu noktada sağ kısımda yazan şartlara uymalı ve birinci NSX manager ile aynı şifreleri kullanmalısınız. Eğer ki bir şekilde mevcut password expired durumda ise şu makaleden yararlanabilirsiniz : https://kb.vmware.com/s/article/70691

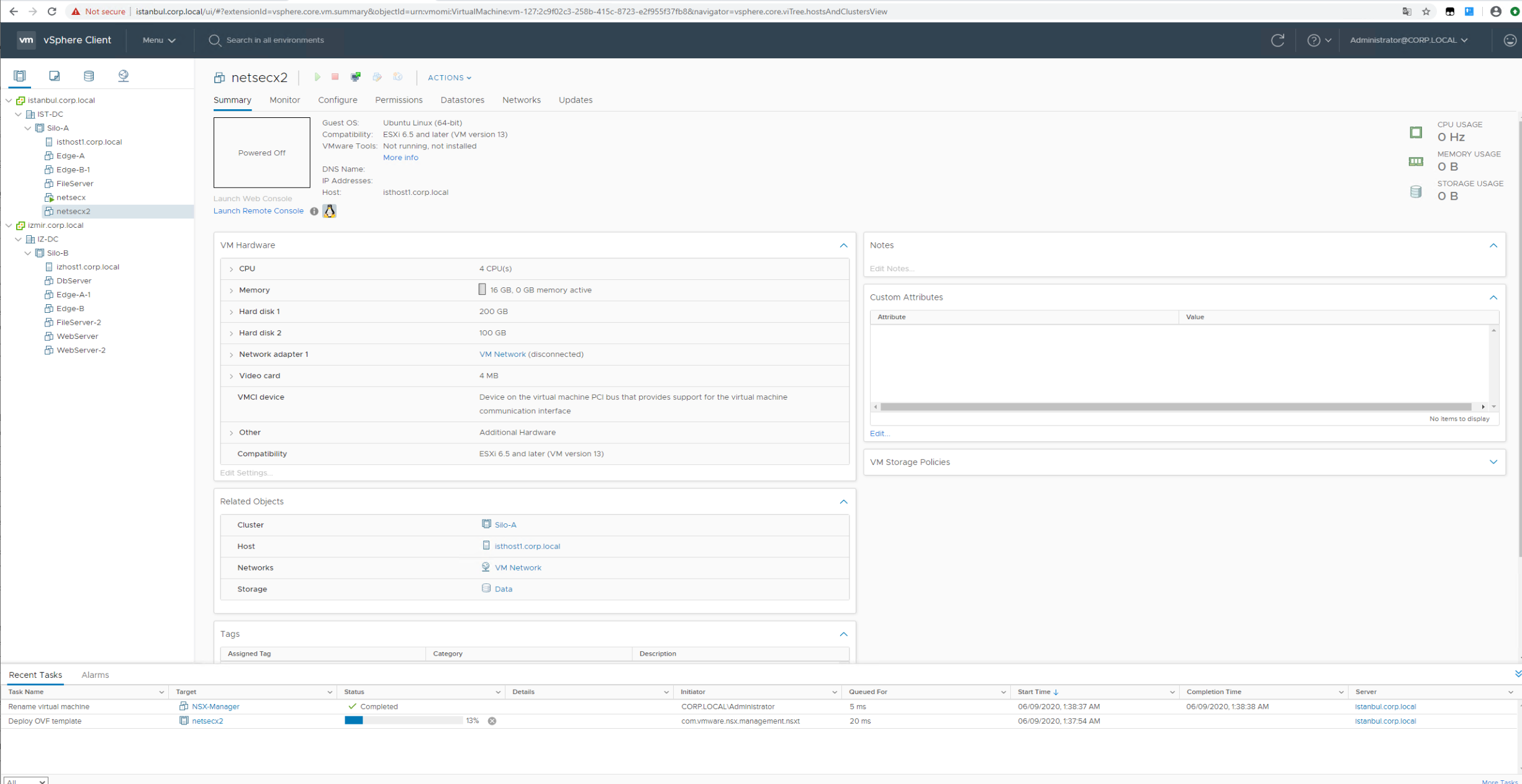

Install Appliance butonuna bastıktan sonra durumu NSX UI veya vCenter ekranından izleyebilirsiniz. Öncelikle ovf deploy edilecek sonrasında cluster mekanizması aktifleşecek ve servisler ayağa kalkacaktır. Üçüncü Node’u eklemek için aynı işlemi tekrarlayın.

vCenter ovf deployment süreci.

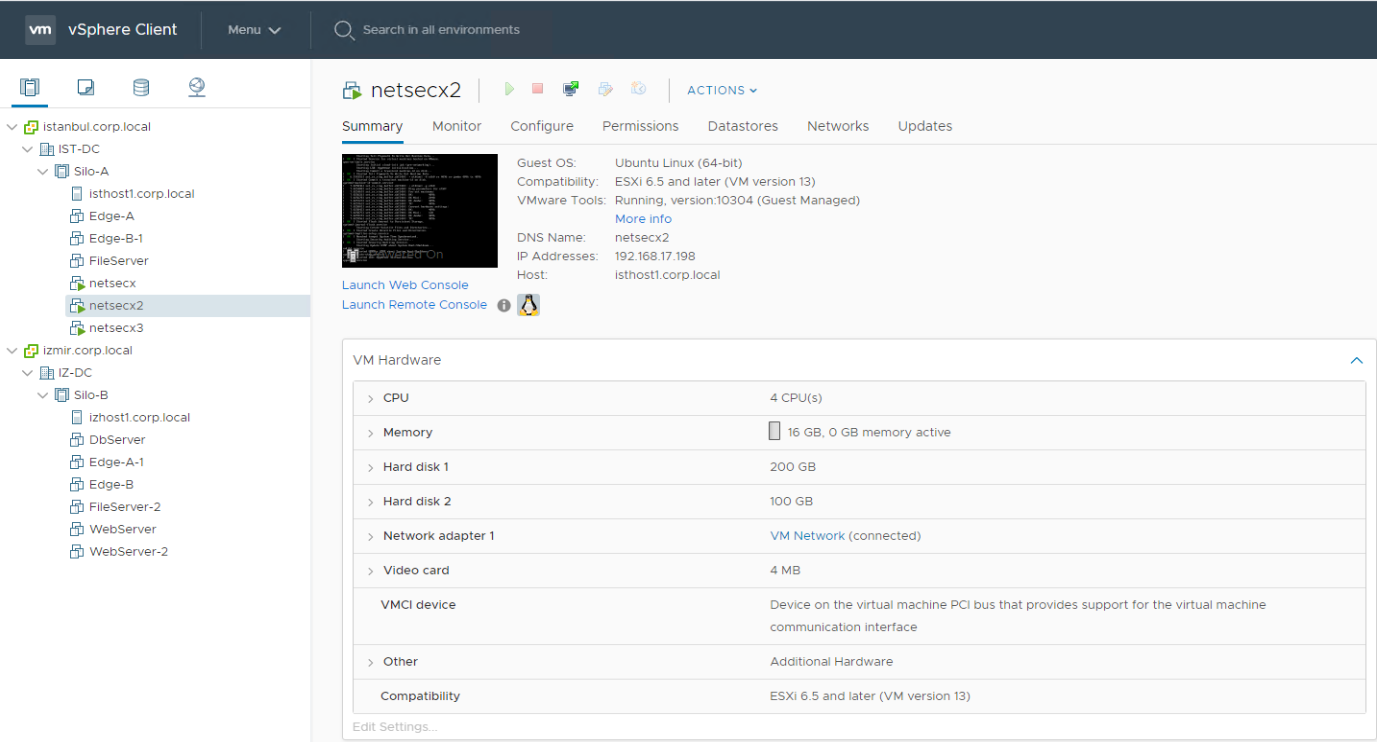

Deployment bittikten sonra VM’ler otomatik olarak power-on olacaktır.

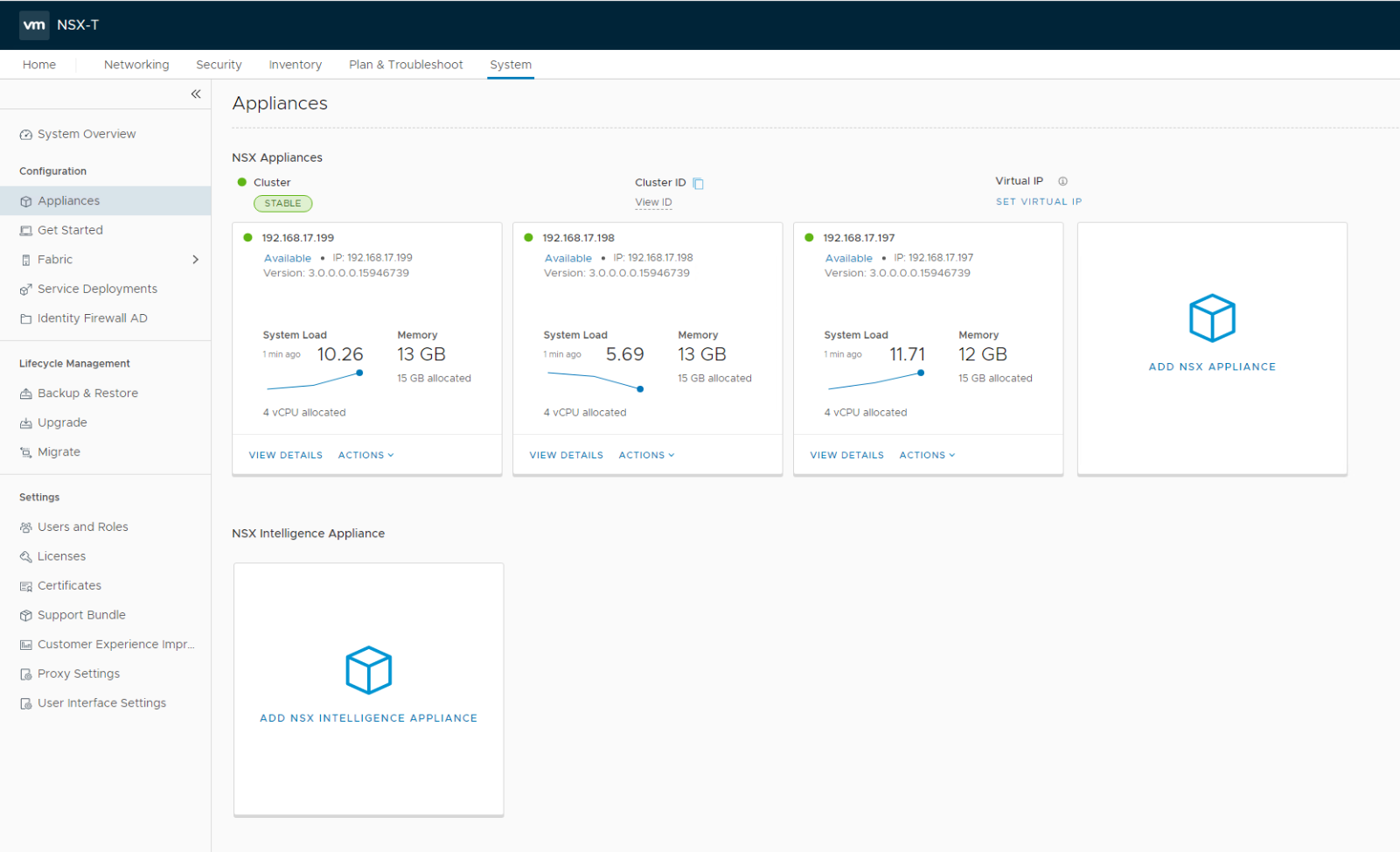

Cluster otomatik olarak kurulup servisler ayağa kalktıktan sonra görmeniz gereken ekran aşağıdaki gibidir.

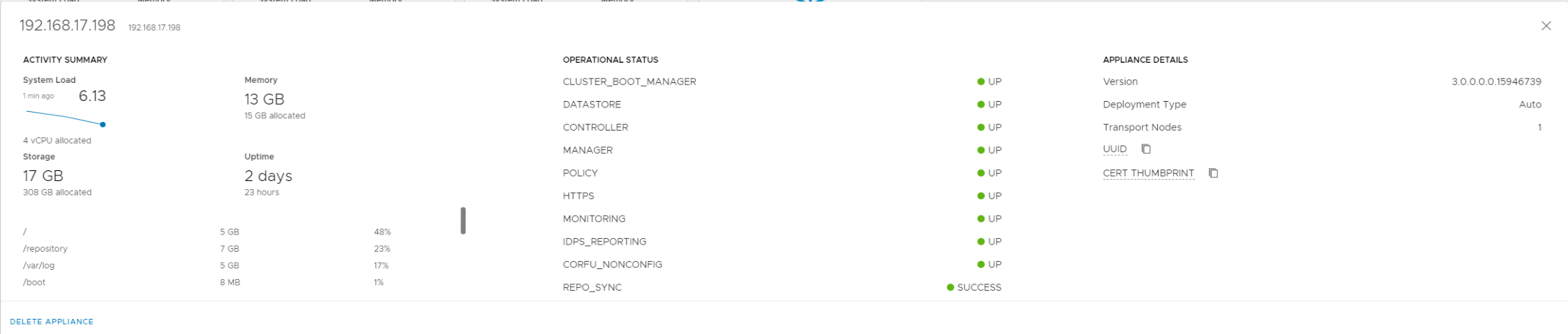

Örnek bir appliance için View Details’e tıklayarak sağlık durumunu kontrol ettiğimizde tüm servisleri UP olduğunu görmekteyiz.

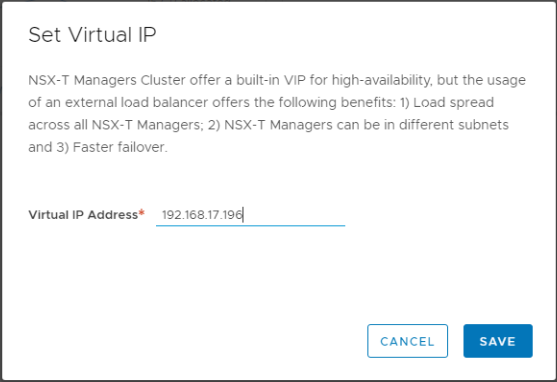

Bu noktadan sonra Appliances Ekranında “SET VIRTUAL IP” butonuna tıklayarak bir cluster IP’si belirliyorum

İşlem tamamlandığında alttaki görselde gördüğümüz gibi VIP etkinleşecek ve hangi NSX Manager’a assign olduğunu gösterecektir. Bunun anlamı siz ne zaman VIP kullanırsanız assign edilen NSX Manager’a yönleneceksiniz.

NSX Manager Cluster Kurulumu (CLI)

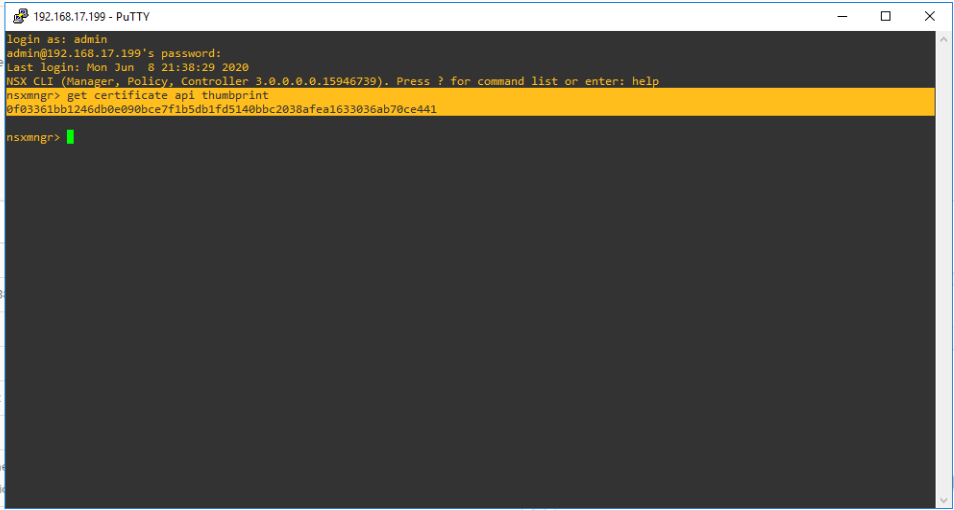

UI kurulumu gibi cli’da gayet basit. İşleri otomasyonla yapmak isterseniz alternatif olarak kullanılabilir. CLI ile cluster kurulumu yapabilmek için öncesinde üç adet NSX Manager’i vCenter ortamınıza deploy etmiş olmanız gerekiyor. Nasıl yapıldığına dair soru işaretleri varsa bir önceki konuma dönüp bakabilirsiniz. Burada önceden deploy ettiğim nsxmngr isimli node’uma admin user’ı ile bağlanarak aşağıdaki komutla cluster api thumbprinti alıyorum. Bu thumbprint cluster join için diğer node’larda kullanılacak.

get certificate api thumbprint

Thumbprinti birinci node’dan edindikten sonra aşağıdaki formatta bir join komutu hazırlamak gerekiyor. Burada bize lazım olan bilgiler şu şekilde;

- Cluster IP thumbprint

- NSX Manager IP’si

- Cluster ID

- Username

- Password

Tüm bu bilgiler birinci NSX Manager’dan elde edilecek bilgilerdir. Cluster ID’yi edinmek için;

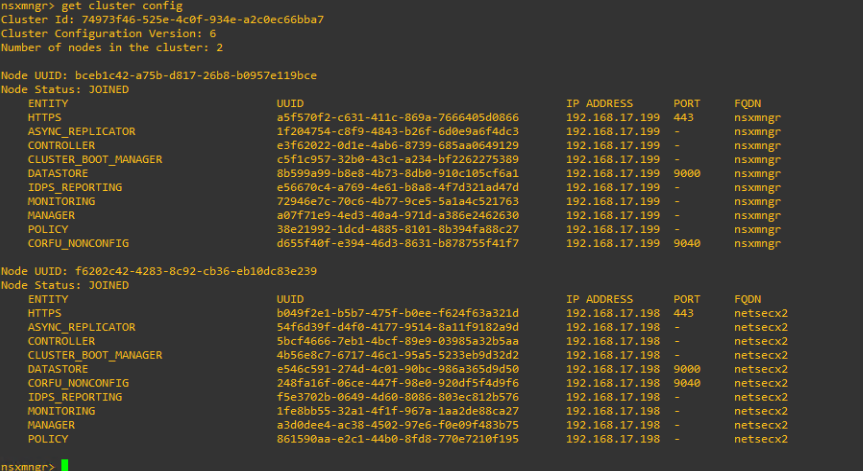

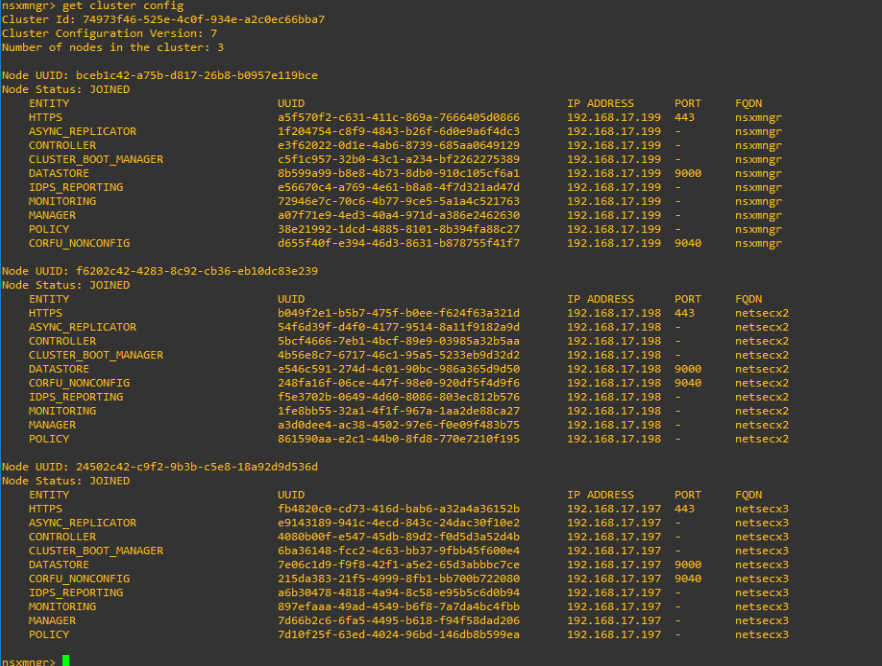

get cluster config

Komut formatı;

join NSX-Manager-IP cluster-id cluster-id username NSX-Manager-username password NSX-Manager-password thumbprint NSX-Manager-thumbprint

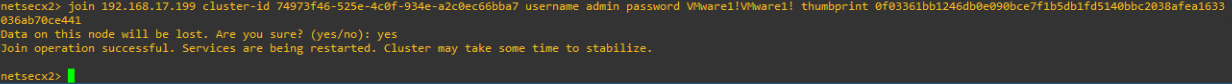

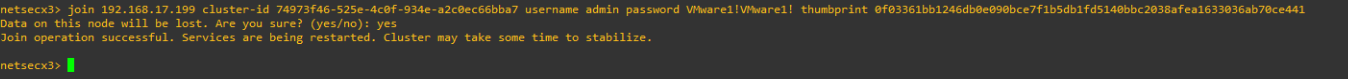

İkinci node’da komutu uyguluyorum ve tüm verinin kaybolacağını söylüyor. Devam ediyorum.

Cluster’a katılma işlemi saniyeler içerisinde gerçekleşecektir ancak servislerin ayağa kalkması ve veri senkronizasyonu zaman alacaktır.

Öncelikle cluster katılım durumana bakmak için “get cluster config” komutunu kullanabiliriz.

İşin bitip bitmediğini anlamak için

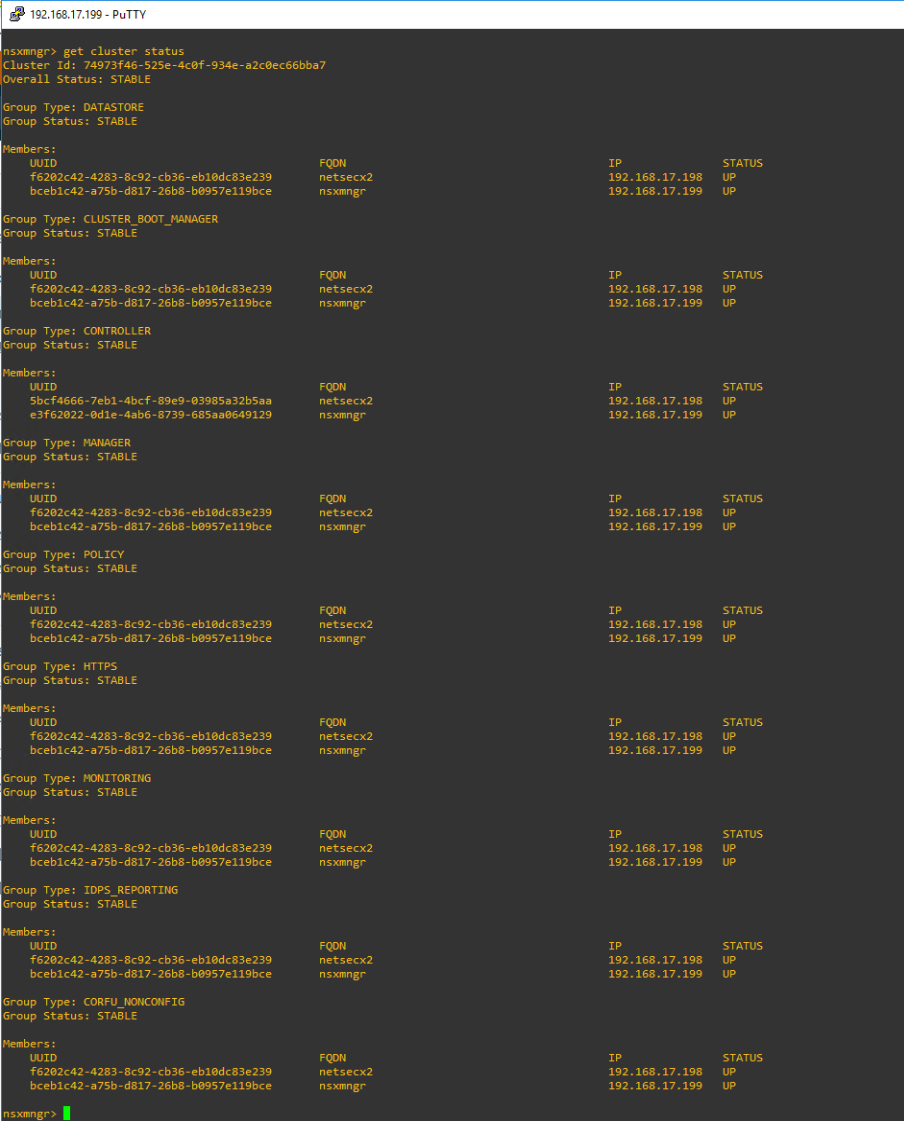

get cluster status

komutunu kullanabilirsiniz. Burada tüm servislerin her iki manager içinde UP durumda olması gerekmektedir.

Her iki node için de tüm servislerin UP olduğunu gördükten sonra üçüncü node’a admin user ile bağlanarak ikinci node’da çalıştırdığım aynı komutu uyguluyorum. Sonrasında servislerin oturma süreci var 🙂

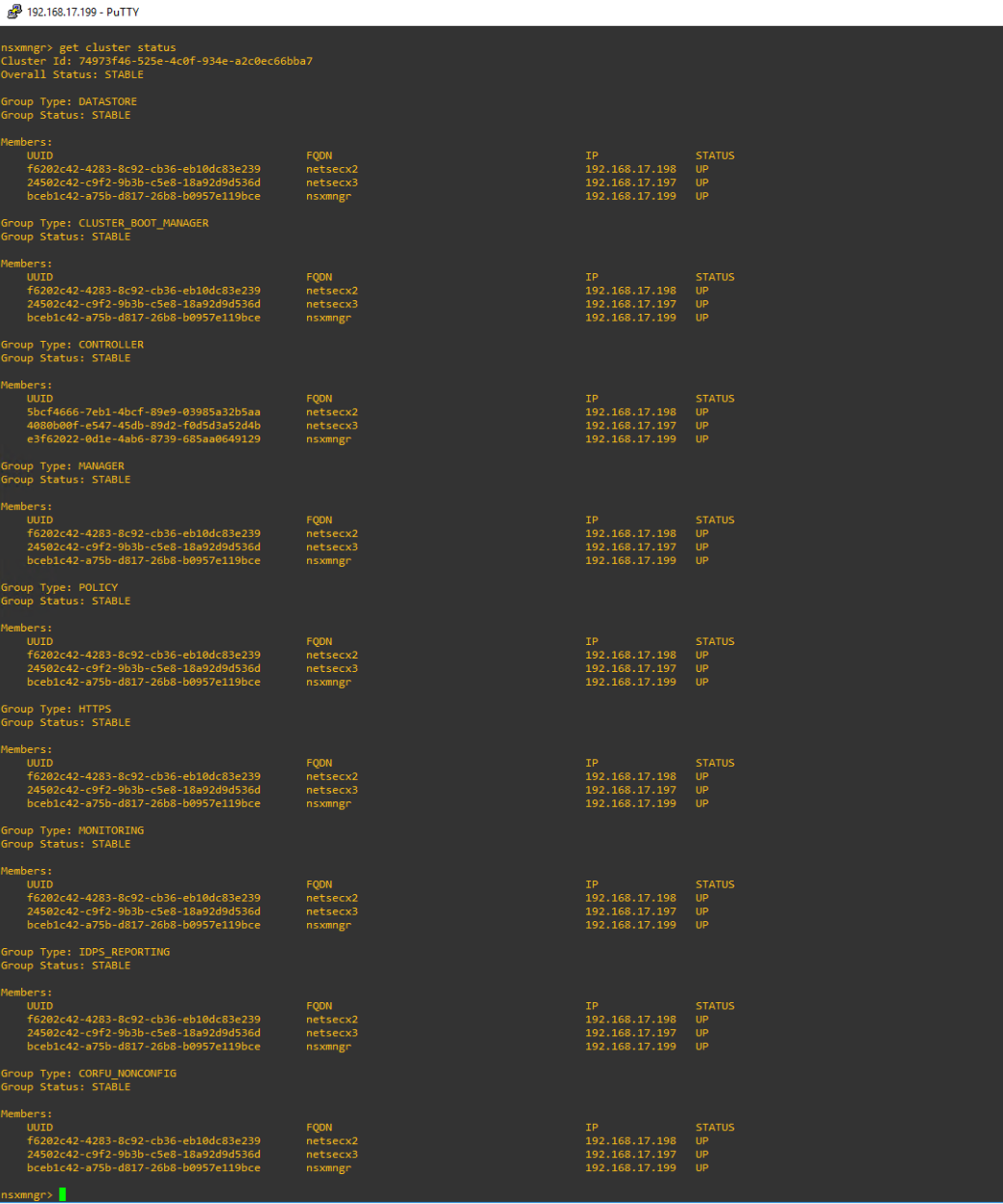

Cluster join operasyonu başarıyla tamamlandıysa yine “get cluster status” ve “get cluster config” komutlarını tüm managerlarda çalıştırarak durumu görebilirim;

Son olarak işlemler tamamlandığında UI içerisinde System > Appliances altında üç manager’ında UP durumda olduğunu göreceksiniz.

Sonuç ve Yorumlar;

Hazırlaması zor ve zaman alan bu yazıyı sonunda bitirdim 🙂 Anlattığım üzere NSX Manager clustering mekanizması bizler için İş sürekliliği ve yüksek kullanılabilirlik sağlamakta. Production ortamları için olmazsa olmaz bir mekanizmadır. Cluster kurulduktan sonra yapılabilecek daha iyi bir iş varsa o da cluster node’larını bir Load Balancer arkasında konumlandırmak olabilir.. Bu konuyu da ilerleyen seviyelerde anlatabilirim.

Görselimiz;

tyilmaz.net teletek.net.tr sunucularında barındırılmaktadır.

tyilmaz.net teletek.net.tr sunucularında barındırılmaktadır.

2 Responses

[…] NSX-T Manager Cluster Kurulum ve İncelemesi […]

[…] NSX-T Manager Cluster Kurulum ve İncelemesi […]